中国所谓的AR领头羊Rokid,跟Apple Vision Pro产品差距有多大?

文 | aR 星人,作者 | 李沛霖

懂行的人知道 AR 比 VR 难 10 倍不止!最近被疯抢的 Apple Vision Pro 属于外观滑雪镜形态以 VST 模拟 AR 功能的 VR 头显,简单说就是用摄像头 " 透视 " 的 VR。即使对于苹果,基于光学透视 OST 的 AR 都堪称圣杯。

一个动不动拿到大额融资的国内 AR 创企,所谓中国 AR 领域的 " 领头羊 ",之前最早做语音识别、智能音箱,创始人散发着满满的 geek 气息。在许多先行者包括巨头微软 Hololens 和 Magic Leap 都几年拿不出一款新品、时不时被传团队解散,国内相关企业如影创倒闭甚至创始人因融资纠纷有牢狱之灾,AR 企业几乎集体揭不开锅的时候,Rokid 的风光让人疑窦丛生。

AR 的直观理解

Rokid 的 AR 和 Apple Vision 的 AR 截然不同,很难归类为同一类产品。但两家都瞄准着挖掘消费电子 AR 头显的金矿。

相比电视机的大屏幕 、PC 的中屏幕、手机的小屏幕,如果你眼前的三维空间成为一个新的 " 窗口 ",现实世界的 " 实物 " 全部可以虚拟、任意塑造、增强,戴上一副眼镜或头显能够实现眼前空间的彻底数字化,对于生活和工作完全是颠覆。

我们见证过 iPhone 风靡全球,它真正发明了智能手机,如今跟工作和生活息息相关,出门手机低电量甚至会带来生存焦虑。同样道理,未来我们可能也离不开下一代 AR 消费电子,即 " 空间个人计算机 "。

要理解 AR,要知道先行一步的 VR 本质上是一个什么东西。就像你看 3D 电影,VR 眼镜类似电影幕布整个 " 包裹 " 住你眼睛,你看到的完全是计算机生成的视觉信息,沉浸其中。戴上 VR 眼镜会让视觉和外界处于物理断联的状态,因为 VR 要隔绝外部光线要打造沉浸,现实里完全隔绝外部视线是危险的,VR 要拓展到工作和生活场景,必须要实现对周围环境的感知。VST,即 Video See Through,就是 VR 眼镜感知外部的解决方案,高清摄像头和相应的视频流处理单元即对应的 VST 硬件。

AR 与之不同的是,它一般是 OST,即 Optic See Through,它在物理形态上不遮挡外部光线,不追求完全沉浸,用户看到的是外部环境光和计算机生成的图像的叠加。AR 可以设计成沉浸或不沉浸,类似电镀调光技术还可以随意调整环境光透过率,当外部进入的环境光降低到 0,就变成了类似 VR。

直观理解,VR 追求沉浸在物理设计上隔绝了眼睛能直接看到外部光线,必须借助 VST。AR 是相对 " 透明 " 设计,它允许一部分或绝大部份光线穿过光学镜片进入眼睛。

苹果 Vision Pro 所演示的 VST 路线

库克之前对 AR 的兴奋完全出于真情流露。收购供应链新锐创企、关键软硬件默默自研、等待基础技术进步和成熟,苹果在推出 Vision Pro 之前不知道蛰伏了多久,Vision Pro 也被期待是下一个 iPhone 时刻。

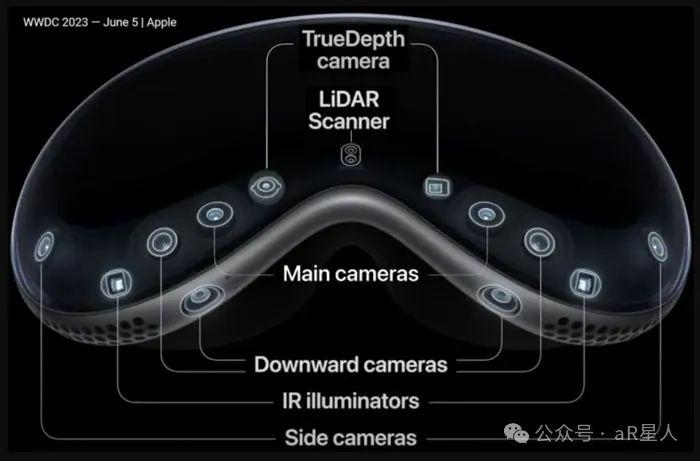

从终端硬件上看,Apple Vision Pro 的核心处理器 M2、专用传感器数据实时处理器 R1、高度定制的类 Pancake 的 3 片式透镜,来源于多年自研和收购前沿技术公司,并且做了深度整合。数量庞大的多种类传感器,包括用于眼球追踪的红外相机、三维空间感知和建模的 LiDar Camera 和深度相机、前向和侧向覆盖多个角度的高清 RGB 摄像头,带来的眼球追踪 + 裸手手势 + 语音交互,从硬件到算法上的调教一出场就站在行业的顶峰,真实效果震撼了许多人。Vision Pro 在 VR 头显的易用性、使用频率和可能的场景扩张上蕴藏巨大潜力。

Vision Pro 所演示的 Eyesight 功能,覆盖着玻璃罩的曲面 OLED 多角度格栅式显示,基于深度学习的脸部建模和数字头像(表情)传递,外部动态的智能化提醒和切换,让佩戴头显的用户自然且巧妙地感知外界信息。相比之下,以往佩戴 VR 头显的用户和其他人几乎无法正常 " 交流 ",人与人之间的视觉割裂,陷入信息孤岛,环境安全和友好几乎是无法解决的问题。

三言两语很难完全讲清 Vision Pro 的领先究竟在哪个层次。相比来自 Meta、字节 Pico 的已有同类产品,有些媒体将 Vision Pro 的领先概括为 " 硬件堆料 ",显得浅薄且可笑。苹果公司对用户需求的理解,产品形态和人机交互 " 规范定义 " 的拉力,富有魔力的营销和对用户体验的拿捏,这种自带的扭曲现实力场让 Vision Pro 被迅速抢购一空。可以预见,我们很快就可以看到竞品在功能上 " 跟进 ",外观上借鉴,甚至直接粗暴抄袭。

Vision Pro 可以说充分外显了苹果领先时代的产品哲学和创造底蕴。风口之下的另一边,在中国所谓的 AR 企业领头羊,被媒体描绘为 " 一杯酒融一个亿 " 的 Rokid,今年上半年推出了 Rokid Max 折返式光路 BirdBath 原理的 AR 眼镜,这种几乎只有显示功能的 OST AR 眼镜,产品原理和售价相比 Vision Pro 差别巨大。

Rokid 在国内资本市场被追捧据说源于这家公司的 " 人机交互 " 基因,但强大的硬件是应用、操作系统和完整生态的基础载体,没有一个成熟且达到一定渗透和使用率的硬件终端,Rokid 频繁举办的开发者活动、对于自研空间操作的宣传,不知道支点在哪。基础逻辑可以说完全不通。

Rokid 相比同行如已经倒闭的影创,同样做 BirdBath AR 眼镜、经常参与国外专业技术组织研讨和展览活动的 Xreal,以及 TCL 孵化的、同时推进两条产品线的雷鸟创新,包括 BirdBath AR 眼镜以及全彩显示 Micro LED 搭配光波导 OST 的 AR 眼镜,Rokid 身上的疑点简直不要太多。

Apple Vision Pro 对比 Rokid Max,究竟有怎样的差别?

首先,产品原理。VR/AR 头显的产品原理其实并无本质区隔,它们都可以概括为:由计算机生成的图像经过光学调整,在非常近的距离让眼睛对焦。

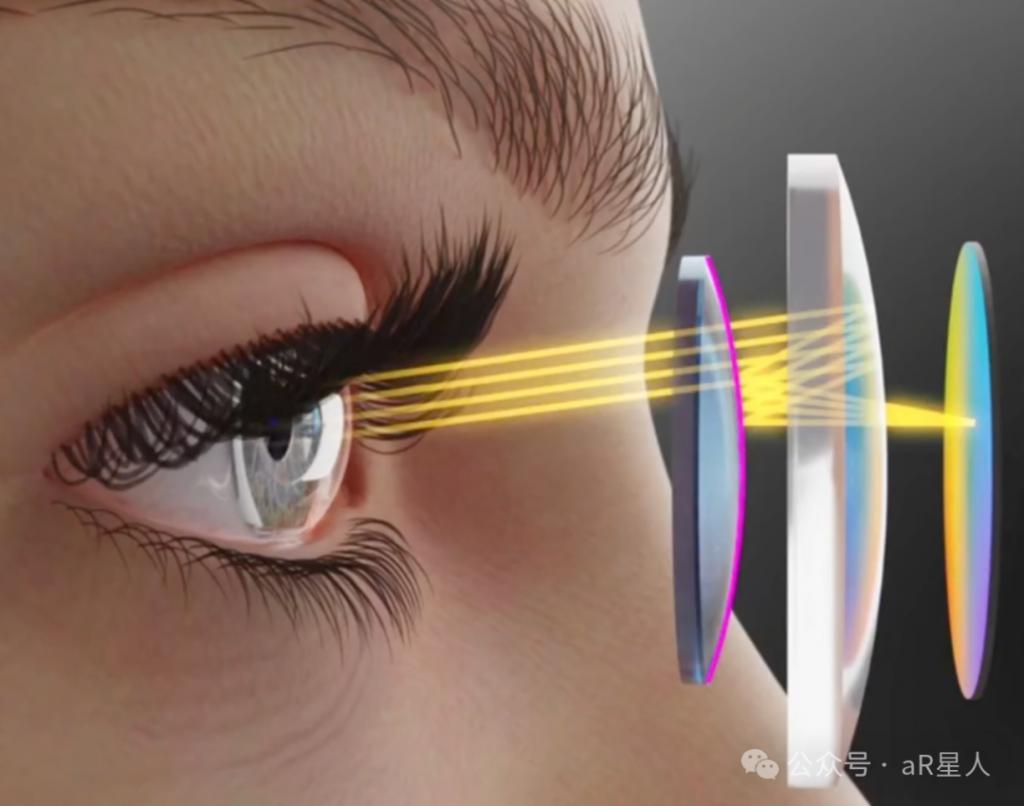

当计算机实时生成的图像在一小块 " 显示屏 " 上出发,图像光源经过透镜放大,在设计好的光路中传输,实现超短距离的对焦,再进入瞳孔,我们就看到了虚拟图像。AR 与之基本类似,不同的是,AR 的小屏幕并不像 VR 一般放在眼睛前方,因为这样会遮挡外部视线,它一般设计在不遮挡视线的顶部镜架或侧部镜腿位置。AR 生成的虚拟图像经过光路,会和外部真实光线一起进入眼睛。

Apple Vision Pro 所使用的多透镜 Pancake 折叠放大光路,图像光源来自眼睛前方的微显示屏

BirdBath 原理 AR 眼镜,图像光源来自顶部微显示屏(示意图来自鸿蚁光电公司)

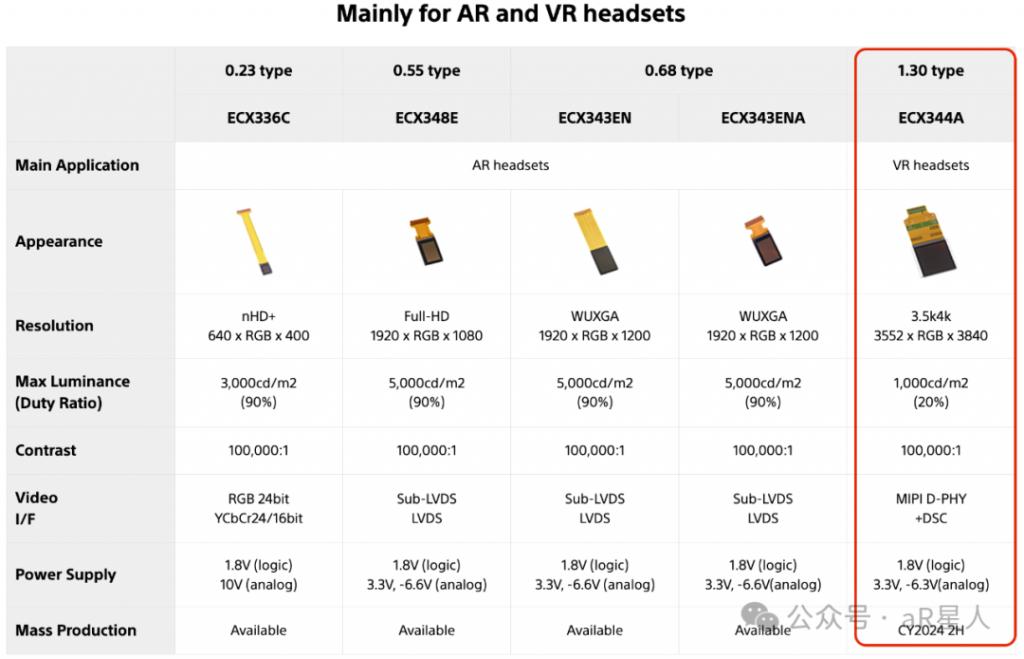

第一个关键对比,生成图像的 " 小屏幕 "。这块小屏幕分辨率必须足够高,还需要非常高的亮度,因为不同的光学模组光效率大相径庭,要保证一定的入眼亮度,以及丰富的的色彩、对比度,低耗电等。迄今为止最佳的解决方案是硅基 OLED 屏幕,即硅芯片驱动的超密集 OLED 微型 " 显示器 ",索尼已经实现指甲盖大小的面积上实现 4K 分辨率的硅基 OLED 小屏幕。多家科技巨头还在研发 Micro LED,不过 Micro LED 目前无法在一块硅基板上同时实现 RGB 三色超高亮度显示。

微显示屏作为新兴显示产业,终端品牌都需要从供应链厂商采购。Apple Vision Pro 使用了 2 块索尼 4K 分辨率的 OLED 微显示屏作为内屏,一块异形柔性屏 AMOLED 作为前向 eyesight 显示(外屏),后续传言还会将视涯和京东方加入供应链。微显示屏需要在分辨率、色彩、功耗、成本上不断进化,头显的 " 空间分辨率 " 对于提升产品体验至关重要,面板巨头主导着技术进步和批量生产良品率。

之前媒体流传的 BOM 清单显示,售价 3499 美元的 Apple Vision Pro 硬件物料成本约 1509 美元,其中,索尼供应的两片 4K 分辨率 OLED 内屏一片 350 美元,合计 700 美元,几乎占据了物料成本的一半,为成本最高的零组件。相比之下,台积电代工的 M2 处理器仅需 120 美元。

2023 年年中发布的 Apple Vison Pro,采用了 4K 分辨率的昂贵 OLED 微显示屏,(型号可能是官网显示的 1.30type ECX344A),相比 2023 年上半年发布 Rokid Max,还停留在 1080P 分辨率。

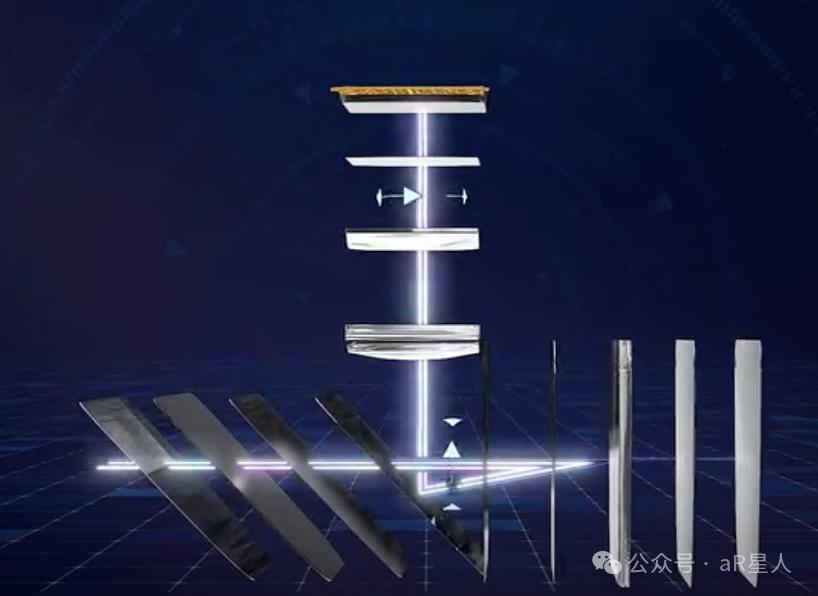

第二个关键对比,光路传输,即光学显示透镜的设计,VR 头显一般有透镜、涅菲尔透镜、Pancake 透镜模组三种方案。它们之前的差异就是模组轻薄程度(关键)和一系列影响显示效果的光学特性,如 FOV、光效率、MTF、杂散光抑制、像差和色差消除、超高分辨率适配等。Pancake 最为轻薄,关键光学参数综合最好,但也是近乎 10 倍于传统透镜的价格。

根据多方信源,Apple Vision Pro 采用了定制的多片式(3 片)Pancake 透镜模组。苹果官方新闻稿中明确提到 " 定制的折反射透镜 " 字样,Pancake 属于折返射透镜的其中一类,苹果已收购的光学公司 Limbak 就以折反射方案闻名,此前还推出了某种 " 超级 Pancake" 透镜设计。

熟悉光学透镜设计和制造的人知道,Pancake 本身就是一个刚出来没几年的前沿高端方案,适配超高分辨率屏幕的 Pancake 模组,(根据同行 HyperVision 解析)Vision Pro 使用的还是多片式带有独特非标曲面的定制 Pancake 模组,这意味着对齐、加工精度和量产一致性是个非常大的挑战。透镜模组的设计,分光、极化偏振、消除鬼影的各类光学镀膜和层片需要有非常深厚的光学研究和积累。

Apple Vision 足够独创且研究艰深,构筑了一定的产品壁垒,头显整体的精密和复杂从光学透镜一个组件上就能体现。相比之下,中国的 AR 厂商如 Rokid Max 似乎还是用中国供应链厂商的整体 BirdBath 模组方案。惠牛、鸿蚁或视涯,直接拿来用。

严格地说,Apple Vision Pro 这种不同原理的复杂头显、完全不同的产品形态,Rokid 不应该拿来对比。但同类型的 BirdBath AR 眼镜,Xreal 能够独立设计光引擎 + 透镜模组,并且在无锡有光引擎组件的量产工厂,这也是 Xreal 能够在国外专业技术组织 SID Display VR/AR 专场频频亮相的原因。因为即便 BirdBath,也有 PBS 偏振分光棱镜,消除多源头的杂散光、边缘炫光、矫正像差和色差的镀膜,设计光路、适眼距、eyebox、改进 MTF 等诸多细节。

Rokid 即使相比雷鸟创新,雷鸟的 BirdBath 产品线也是拿来主义,但起码雷鸟毫不畏惧另一条产品线 Micro LED+ 光波导方案 " 真 AR 眼镜 " 的技术困难。雷鸟创新虽然直接使用了来自 JBD 的 Micro LED 的 X-cube RGB 三块小面板方案,但成功落地量产,解决了配套的研发、测试、量产一致性的诸多问题。

没有从底层产品原理上最细微处的洞察,对光学的积累和重视,没有完全从 0 到 1 的独创精神,是无法做出真正领先市场的 AR 硬件终端。

第三个关键对比,传感、数据传输 & 处理、人机交互和人机工程对于视觉 - 人脑的深入研究,这是当前技术研发能够拉开差距的关键地方。光学显示透镜和小屏幕都有比较成熟的供应链厂商,昂贵或便宜,好的不好的,大家可以选择。即使苹果、Meta、谷歌近 10 年收购的光学和微显示领域的研究型创企,也基本上处在实验室的超前概念预研阶段,能真正落地整合进自家产品且商用的很少。体验做不到超前的独一档。

VR 跟裹住眼睛的 3D 幕布不同的是,VR 需要能跟外界进行交互,比如手势交互、眼球运动、头部运动、肢体体感、指环或手柄。实现交互的硬件基础,设计专门的高精度传感器,比如基于 dToF 原理的激光雷达、基于红外点阵特征识别的深度相机、高清 RGB 摄像头,以及相匹配的先进算法。传感器的数量、分布、精度、算法的效果会有明显差异。

以 Apple Vision Pro 为例,它将眼球追踪 + 手势交互 + 语音操作做到了极致,并且将其引导成 " 空间计算 " 最舒服最符合直觉的交互模式。为此,Apple Vision Pro 在传感器的硬件配置和算法上下了非同一般的功夫,比如为了实现高精度的眼球追踪,别家都是左右眼各一个红外相机和数个 IR LED 等,Apple Vision Pro 左右眼各两个 IR Camera+ 环绕眼眶更多的 IR LED。已经公开的专利也显示,苹果在视网膜透视、特征识别上进行了大量的研究,为了进一步提升精度,甚至有工业级的激光干涉测量原理的方案被披露出来。

Vision Pro 配备了 4 个定制的红外相机(左右眼各 2 个),使用多达 34 颗红外 LED 灯,可以非常精准的追踪和预测眼球视线的变化,凝视和扫视。数据传输和处理上,Vison Pro 同时搭载了 M2 和全新的 R1 芯片,M2 是桌面级性能非常强大的核心处理器,而 R1 芯片是苹果为 vision pro 设计的传感器数据实时处理定制芯片,类似 iPhone 协处理器,是其实现高性能眼动追踪重要基础。R1 芯片专门处理 12 个摄像头、5 个传感器和 6 个麦克风的输入,以确保内容实时呈现在用户眼前,R1 芯片能在 12 毫秒内将新图像传输到显示屏中,降低图像到屏幕的延迟,以超高的精度、极低的延迟识别用户所在的环境以及用户的手势和眼球的运动,精准分析出需要渲染的场景,从而实现动态注视点渲染功能。通过 Vision Pro 提供的低延迟、高精度信息输入,用户得以从手柄控制器中解放出来,只需眼睛注视即可准确地选中元素,以极其自然、优雅且直观的方式与数字世界进行交互。

Vision Pro 让眼球追踪真正落地成为主要交互方式,还是令一众观察家惊讶不已。

微软 HoloLens 2 软件开发指南中曾提到,人眼视线的运动是不规则且跳跃的,并且速度很快。可能在用户完成点击动作之前,视线早已经飘走,因此将快速眼睛凝视信号与慢速的控制输入结合起来需要格外小心。

此前 Meta Reality Labs 的一份关于 " 手柄、头动以及眼动交互 " 的一份研究指出,以 90Hz 运行的平均精度误差低于 1 ° 的眼动追踪系统(在无光标或其他反馈的条件下),它在易用性、采用率和疲劳度相较于头部输入(Head input )分别提高了 66.4%、89.8% 和 116.1%,而相较于手柄输入则分别降低了 4.2%、8.9% 和 116.1%,不过它的失误率是三者当中最高的。

除了强大的传感器和实时数据处理,在算法方面,苹果也早早进行了布局。根据外部资料,早在 2017 年,苹果收购德国眼动追踪技术开发商 SensoMotoric Instruments(SMI),这是一家专注于该细分领域的头部企业,已有 30 余年的发展历史。

苹果前员工 Sterling Crispin 爆料称,苹果围绕 Vision Pro 有一个专门研究神经技术的开发小组,而他所做的工作之一是通过 AI 预判用户的操作行为。他提到," 你的瞳孔会在你点击某物之前作出反应,部分原因在于用户对接下来发生的事有所期望。因此,可以通过观察用户的眼睛行为并配合实时反馈的 UI 来增强用户大脑的预测性瞳孔反应,从而创建生物反馈。" AI 算法的加入,是 Vision Pro 的眼动交互备受好评的重要原因之一。

眼球追踪只是苹果 Vision Pro 在人机交互体验高出同行一截的显性部分。在传感、数据传输、计算、人机交互软硬件方案上,亮点实在是太多。

比如在 AR/VR 刚兴起时,业内就几乎确认了裸手交互是重点方向,只是要想做好手势交互精准且流畅,技术难度不小。而裸手交互被苹果真正推向了极致,展现了与市场上其他玩家完全不同的策略。Vision Pro 配备了多个用于手势识别的摄像头和传感器,可以检测腰部以下的手势,用户还可以把手放在膝盖上进行操作,这是之前 VR 厂商做不到的。

主流 VR 的手势追踪必须将手放在摄像头 FOV 范围内,使用时双手必须微抬或举在身体前面,时间一长就非常累,导致用户体验差。而 Vision Pro 则拥有 6 颗 SLAM+ 手势摄像头,其中有两颗向下的摄像头专门捕捉手垂放在腿上的视角。另外,还有两颗斜向下的摄像头同时兼顾 SLAM 和手势。甚至为了弱光环境下手势识别准确性,苹果还加入了两颗红外 LED 进行辅助。

这种垂直视角的摄像头,专门用于捕捉大部分时间、不抬手的时候的手势,因为很多时候双手应该自然垂放在腿或桌子上,符合人体工学逻辑。苹果 Vision Pro 是 AR/VR 中的首家采用这一方案的设备,属于独一份。

Apple Vision Pro 眼球追踪体验刷新了行业认知,多种类型传感器硬件、分布、算法研究之深很难给出准确评估,硬件底层还有专门的传感器数据实时处理芯片 R1,极限压缩交互上的反馈(图像)延迟,Apple Vision Pro 在人机交互的软硬件的方方面面,几乎独创了整个方案。其他厂商短时间几乎没有可能追赶得上。

更值得深度思考的是 Eyesight。根据 Vision Pro 官方发布会的说法,Eyesight 是一项引进先进 AI 后才解决了某项一直阻碍团队重要难题的交互方案,它完全不同于传统 VR 的产品视角,少有人知晓的细节:Eyesight 的硬件实现,让外部摄像头传感器位置偏离常规,相应的矫正算法增加了不少的设计困难。

为了 Eyesight,Vision Pro 多用了一块复杂的曲面 OLED 外屏,增加了曲面玻璃罩的 " 死重 ",为此还需要重新调整传感器分布,进行实时画面矫正,代价不小。苹果也在发布会上花了很大篇幅讲 Eyesight。

国外著名的 AR 专家 Karl Guttag 在个人博客上暗示,苹果在 VR 头显上击中了关键点,深思熟虑后为了 Eyesight 在产品上做了重大妥协,体现了这家公司对产品和用户的深刻洞察力:Eyesight 做到了外围视觉的动态感知,佩戴头显的用户能够真正融入日常环境,与他人更符合人类的方式互动,让 VR 头显开始真正具备大众消费电子产品的可能。基本可以预见,Eyesight 马上也会成为行业的 " 高端标配 "。

再回过头来看,中国的 AR 创企代表 Rokid,有位参加 Rokid 首届高校 XR 内容创作大赛的选手在媒体上这样写道,

Rokid Max Pro,这款眼镜从外观和手感 / 重量上其实与 Rokid Max 基本没有什么区别,就是两眼中间位置增加了一个摄像头。而利用这个摄像头以及另一款目前还不能公布的硬件,Rokid Max Pro 用户能实现 SLAM( 即 Simultaneous Localization And Mapping 视觉定位和建图)、3D 裸手交互等功能。嗯,我相信你一定见过同类产品上利用双目视觉实现该功能的产品,但 Rokid Max Pro 却只用单目,这效果真的 OK 么?我现在不能透露有关它的一些技术细节,但我可以说的是这款产品在定位的 " 稳定性 " 以及手势动作识别 " 精确度 "、" 延迟性 " 上的表现令我惊叹 ....

还在纠结和对比单目还是双目的视觉 SLAM... 传感器的精度、数据的延迟、数据流的处理模式、有没有专属芯片和定制传感器这种底层创新暂且不表,产品宣传如此高调," 空间计算操作系统 "、" 超前的应用开发生态 "、" 人机交互重大创新 "、"AR 空间创作工具 ",投资人是真不懂吗?

如此简陋,毫无技术含量的供应链组装品,却成为中国 AR 企业的代表,融资如喝水一般简单,不禁莞尔一笑。底层创新是如此之难。但你刚挖好农村宅基地的地基,却要在这上面垒起来上海中心大厦?

这一波风口,飞上天之后,总该拿出点硬货。我不信投资人真的不懂 Apple Vision Pro 的创新有多么深刻。在历时两个月的深入研究后,我相信真正的创业者应该出发了。